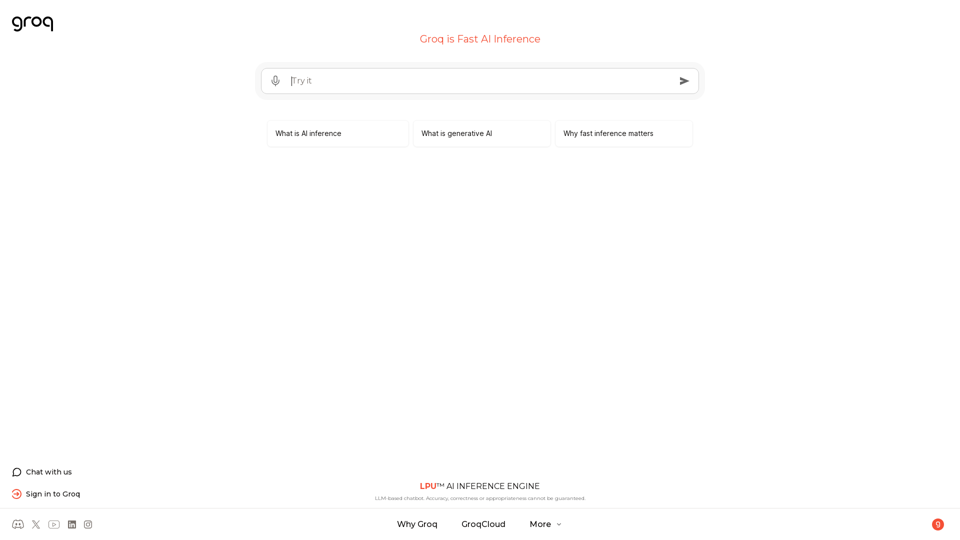

Groq est une entreprise technologique de pointe spécialisée dans l'inférence IA rapide. Ils proposent une plateforme basée sur le cloud appelée GroqCloud qui permet un déploiement et une gestion rapides des modèles d'IA, en se concentrant sur des processus d'inférence efficaces et rapides. La technologie de Groq est particulièrement bénéfique pour les applications nécessitant des réponses IA en temps réel, telles que les chatbots et les systèmes d'IA générative.

Groq est l'inférence d'IA rapide.

Le moteur d'inférence LPU™ de Groq est une plateforme matérielle et logicielle qui offre une vitesse de calcul exceptionnelle, une qualité et une efficacité énergétique remarquables. Groq fournit des solutions cloud et sur site à grande échelle pour les applications d'IA.

Siège social situé à Silicon Valley et fondé en 2016. Le LPU et les systèmes associés sont conçus, fabriqués et assemblés en Amérique du Nord.

Introduction

Fonctionnalité

Inférence IA rapide

L'offre principale de Groq est sa technologie d'inférence IA rapide, qui permet aux modèles d'IA de répondre rapidement et avec précision aux entrées des utilisateurs. Cette fonctionnalité est cruciale pour maintenir l'engagement des utilisateurs et fournir des expériences fluides dans les applications alimentées par l'IA.

Plateforme basée sur le cloud

GroqCloud, la plateforme basée sur le cloud de Groq, fournit une infrastructure évolutive et sécurisée pour le déploiement et la gestion des modèles d'IA. Cela permet aux utilisateurs de tirer facilement parti des capacités d'inférence rapide de Groq sans avoir besoin de configurations complexes sur site.

Traitement à haut volume

Groq a démontré sa capacité à gérer de grands volumes de trafic, ayant traité plus de 320 millions de requêtes à ce jour. Cela démontre la fiabilité et l'évolutivité de la plateforme pour diverses besoins d'inférence IA.

Moteur d'inférence IA LPU™

Groq propose un moteur d'inférence IA LPU™ propriétaire, auquel les utilisateurs peuvent accéder en se connectant à leur compte Groq. Ce moteur offre probablement des performances optimisées pour les tâches d'inférence IA.

Support pour l'IA générative

La plateforme est bien adaptée aux applications d'IA générative, qui nécessitent une inférence rapide et efficace pour générer du contenu original tel que des images, des vidéos ou du texte basé sur des modèles appris.

Engagement des utilisateurs

Groq propose une fonction de chat pour les clients potentiels afin d'en savoir plus sur leurs services et comment Groq peut répondre à des besoins spécifiques d'inférence IA.

FAQ

Qu'est-ce que l'inférence IA ?

L'inférence IA est le processus d'utilisation d'un modèle d'intelligence artificielle entraîné pour faire des prédictions ou prendre des actions basées sur de nouvelles données non vues. Cela se distingue de l'entraînement IA, qui consiste à apprendre à un modèle à reconnaître des modèles et des relations dans un ensemble de données.

Qu'est-ce que l'IA générative ?

L'IA générative est un type d'intelligence artificielle qui crée du nouveau contenu original tel que des images, des vidéos ou du texte basé sur des modèles appris à partir d'un ensemble de données. Ces modèles s'appuient souvent sur une inférence rapide et efficace pour fournir des réponses précises et pertinentes, en particulier dans des applications comme les chatbots.

Pourquoi l'inférence rapide est-elle importante ?

L'inférence rapide est cruciale car elle permet aux modèles d'IA de répondre rapidement et avec précision aux entrées des utilisateurs. C'est essentiel pour maintenir l'engagement des utilisateurs et fournir une expérience fluide, en particulier dans les applications en temps réel comme les chatbots et les systèmes d'IA interactifs.

Qu'est-ce que GroqCloud ?

GroqCloud est la plateforme basée sur le cloud de Groq qui fournit une inférence IA rapide et efficace. Elle permet aux utilisateurs de déployer et de gérer facilement des modèles d'IA tout en bénéficiant de l'infrastructure évolutive et sécurisée de Groq.

Combien de requêtes Groq a-t-il traitées ?

Selon les dernières données fournies, Groq a traité plus de 320 millions de requêtes (320 052 145 pour être exact), démontrant leur capacité à gérer des volumes élevés de trafic d'inférence IA.

Dernières informations sur le trafic

Visites mensuelles

1.41 M

Taux de rebond

40.04%

Pages par visite

4.23

Temps sur le site(s)

159.20

Classement mondial

34048

Classement par pays

India 10349

Visites récentes

Sources de trafic

- Médias sociaux:1.61%

- Références payées:0.41%

- Email:0.05%

- Références:5.04%

- Moteurs de recherche:44.79%

- Direct:48.10%

Sites web connexes

StressLess est un compagnon de santé mentale alimenté par l'IA. Obtenez un soutien instantané pour le stress, l'anxiété et l'épuisement grâce à un chat basé sur des données scientifiques.

75

Nova Echo AI | Automatisez vos ventes avec l'IA conversationnelle

Nova Echo AI | Automatisez vos ventes avec l'IA conversationnelleNova Echo AI est une plateforme de communication IA révolutionnaire qui personnalise et étend les interactions avec les clients pour les ventes. Effectuez 1800 appels/min, automatisez la nurture des prospects et atteignez des audiences mondiales dans 12 langues. Inscrivez-vous pour une démo gratuite et découvrez l'avenir de l'engagement client.

3.49 K

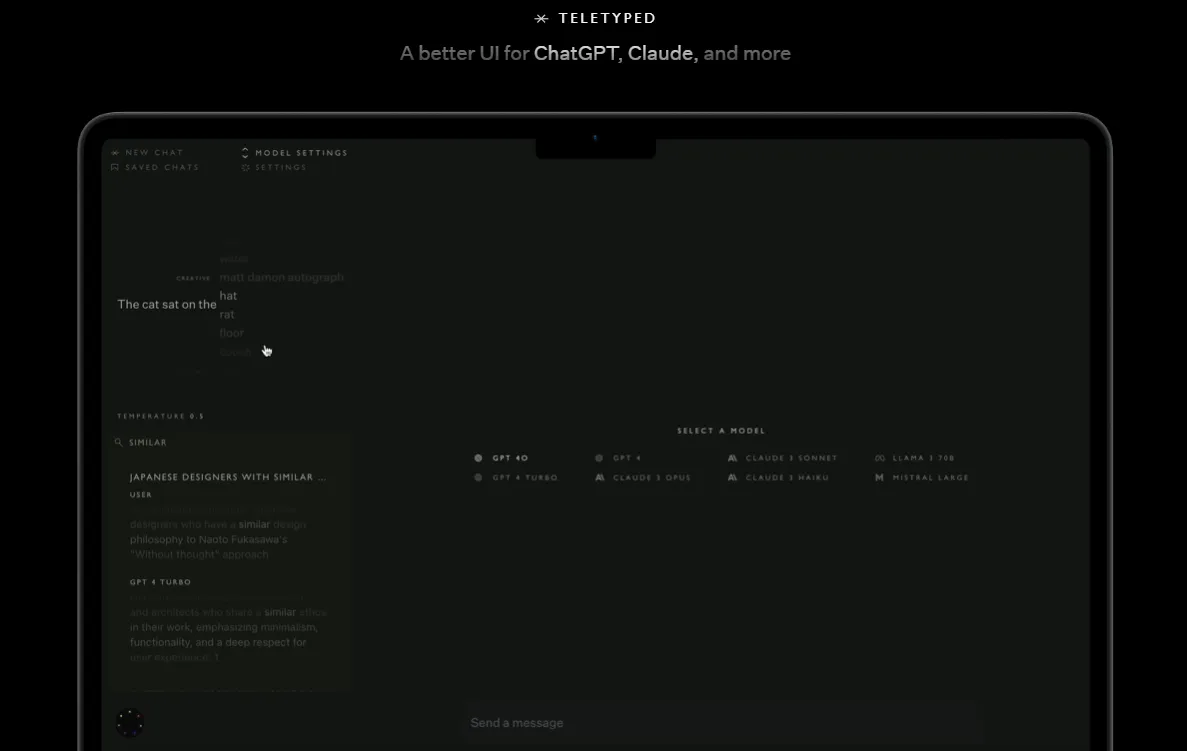

Une meilleure interface utilisateur pour ChatGPT, Claude et plus encore. Les fonctionnalités comprennent la recherche de texte intégral dans les conversations, la sauvegarde des discussions, le changement dynamique de modèle et la possibilité de modifier les réponses du modèle. Personnalisez votre expérience avec divers thèmes visuels et des paramètres de créativité ajustables.

0

Poe vous permet de poser des questions, d'obtenir des réponses instantanées et d'avoir des conversations interactives avec l'IA. Il donne accès à GPT-4, gpt-3.5-turbo, Claude d'Anthropic et à une variété d'autres robots.

15.11 M

Crush-On.AI - No Filter NSFW Character AI Chat - AI GF

Crush-On.AI - No Filter NSFW Character AI Chat - AI GFPlongez dans les discussions NSFW Character AI sans filtres. Faites l'expérience d'interactions NSFW AI authentiques et sans restriction avec des personnages IA - Votre petite amie IA.

12.36 K

Petite amie virtuelle-Dream AI Petite amie virtuelle

Petite amie virtuelle-Dream AI Petite amie virtuelleVirtual Girlfriend - vous pouvez discuter avec une fille virtuelle. Discutez de vos intérêts, partagez vos réflexions ou testez vos talents de flirt.

0