Reflection-70B est un modèle de langage open-source avancé conçu pour résoudre le problème d'hallucination dans les systèmes d'IA. Construit sur le framework Llama-3.1, il incorpore des jetons spéciaux pour structurer le processus de raisonnement et emploie des mécanismes de contrôle plus stricts pour réduire la génération de fausses informations. Le modèle a démontré des performances supérieures dans divers benchmarks, surpassant même certains modèles propriétaires.

Reflection-70B : IA sans hallucination

Reflection-70B est un modèle de langage open-source avancé qui vise à résoudre le problème d'hallucination dans les systèmes d'IA

Introduction

Fonctionnalité

-

Architecture avancée

- Construit sur le framework Llama-3.1

- Incorpore des jetons spéciaux : <thinking>, <reflection>, et <output>

- Structure le processus de raisonnement pour une meilleure précision

-

Formation complète

- Entraîné sur des données synthétiques générées par Glaive

- Utilise de grands ensembles de données pour améliorer le traitement du langage naturel

-

Performances supérieures

- Excelle dans les benchmarks : MMLU, MATH, IFEval, et GSM8K

- Surpasse les modèles propriétaires comme GPT-4o dans plusieurs tests

-

Réduction des hallucinations

- Emploie des mécanismes de contrôle plus stricts lors de la vérification des informations

- Réduit significativement la génération de fausses informations

- Améliore la confiance et la fiabilité des utilisateurs

-

Disponibilité open-source

- Poids disponibles sur Hugging Face

- Sortie d'API prévue via Hyperbolic Labs pour une intégration plus facile

-

Développement en cours

- Version plus puissante, Reflection-405B, attendue prochainement

- Devrait surpasser significativement les meilleurs modèles propriétaires

Comment utiliser ?

-

Accéder à Reflection-70B :

- Visiter https://reflection70b.com

- Cliquer sur le bouton "Start"

- Commencer à discuter avec le modèle

-

Explorer les benchmarks :

- Examiner le tableau de performance pour comparer avec d'autres modèles

- Se concentrer sur les métriques comme GPQA, MMLU, HumanEval, MATH, et GSM8K

-

Comprendre la technologie :

- Se familiariser avec la technique de Reflection-Tuning

- Apprendre comment les jetons spéciaux structurent le processus de pensée du modèle

-

Rester informé :

- Surveiller la sortie de Reflection-405B

- Suivre Hyperbolic Labs pour les informations sur la sortie de l'API

FAQ

Q : Qu'est-ce que Reflection-70B ? R : Reflection-70B est un modèle de langage open-source avancé conçu pour minimiser les hallucinations et améliorer la précision des sorties générées par l'IA grâce à une technique appelée Reflection-Tuning.

Q : Comment fonctionne le Reflection-Tuning ? R : Le Reflection-Tuning apprend au modèle à détecter et corriger ses propres erreurs de raisonnement en introduisant des jetons spéciaux comme <thinking>, <reflection>, et <output> pour structurer son processus de pensée.

Q : Dans quels benchmarks Reflection-70B excelle-t-il ? R : Reflection-70B a démontré des performances supérieures dans divers benchmarks, notamment MMLU, MATH, IFEval, et GSM8K, surpassant même des modèles propriétaires comme GPT-4o.

Q : Comment Reflection-70B réduit-il les hallucinations ? R : En employant des mécanismes de contrôle plus stricts lors des étapes de vérification des informations, Reflection-70B réduit significativement la génération de fausses informations, améliorant ainsi la confiance et la fiabilité des utilisateurs.

Q : Où puis-je accéder à Reflection-70B ? R : Les poids de Reflection-70B sont disponibles sur Hugging Face, et une API doit être publiée via Hyperbolic Labs pour une intégration plus facile dans les applications.

Évaluation

-

Reflection-70B représente une avancée significative dans les modèles de langage open-source, en particulier pour résoudre le problème critique des hallucinations de l'IA. Ses performances dans divers benchmarks sont impressionnantes, surpassant souvent les concurrents propriétaires.

-

L'architecture du modèle, incorporant des jetons spéciaux pour un raisonnement structuré, est innovante et prometteuse pour améliorer la fiabilité de l'IA. Cette approche pourrait établir une nouvelle norme pour des systèmes d'IA transparents et dignes de confiance.

-

La disponibilité de Reflection-70B en tant que modèle open-source est louable, pouvant potentiellement accélérer la recherche et le développement dans le domaine des modèles de langage IA. Cependant, l'efficacité de sa mise en œuvre dans des applications réelles reste à voir.

-

Bien que le modèle montre des résultats de benchmark impressionnants, il est important de noter que les performances dans le monde réel peuvent varier. Des tests plus approfondis dans des scénarios pratiques divers fourniraient une image plus claire de ses capacités et limites.

-

Le développement en cours de Reflection-405B indique un engagement envers l'amélioration continue. Cependant, la communauté IA devrait rester vigilante quant aux biais ou limitations potentiels qui pourraient émerger à mesure que le modèle s'agrandit.

-

L'accent mis sur la réduction des hallucinations est crucial pour établir la confiance dans les systèmes d'IA. Cependant, les utilisateurs devraient toujours aborder le contenu généré par l'IA avec un esprit critique et ne pas se fier uniquement aux sorties du modèle sans vérification.

Sites web connexes

Posez des questions à l'IA gratuitement - Obtenez des réponses instantanées de l'IA avec de meilleures perspectives.

Posez des questions à l'IA gratuitement - Obtenez des réponses instantanées de l'IA avec de meilleures perspectives.Posez des questions à l'IA gratuitement et obtenez des réponses instantanées, fiables et factuelles. Interagissez avec l'assistant d'écriture le plus avancé alimenté par l'IA sans vous connecter !

0

FantasyLife.ai - Laissez l'IA satisfaire tous vos fantasmes

FantasyLife.ai - Laissez l'IA satisfaire tous vos fantasmesLaissez votre personnage AI NSFW satisfaire vos désirs les plus profonds ! Chez FantasyLife.ai, vous pouvez créer votre personnage NSFW idéal, de son apparence à sa façon de parler. Essayez FantasyLife.ai gratuitement dès maintenant !

141

MEILLEUR Chatbot NSFW AI Girlfriend pour Sexting AI - GFNSFW.AI

MEILLEUR Chatbot NSFW AI Girlfriend pour Sexting AI - GFNSFW.AIGFNSFW.AI propose de nombreux chatbots de petite amie NSFW AI pour Sexting AI en ligne. Des discussions NSFW Character AI non filtrées vous attendent. Vivez de véritables interactions sans restriction avec les personnages IA.

0

Crush-On.AI - No Filter NSFW Character AI Chat - AI GF

Crush-On.AI - No Filter NSFW Character AI Chat - AI GFPlongez dans les discussions NSFW Character AI sans filtres. Faites l'expérience d'interactions NSFW AI authentiques et sans restriction avec des personnages IA - Votre petite amie IA.

12.36 K

Générateur d'âme sœur IA - Meilleures petites amies et petits amis IA via Telegram

Générateur d'âme sœur IA - Meilleures petites amies et petits amis IA via TelegramSoulmaite est la première plateforme au monde pour des relations réalistes avec des petites amies et des petits amis IA, avec des compagnons IA virtuels via Telegram. Essayez ce générateur d'âme sœur IA maintenant !

155.52 K

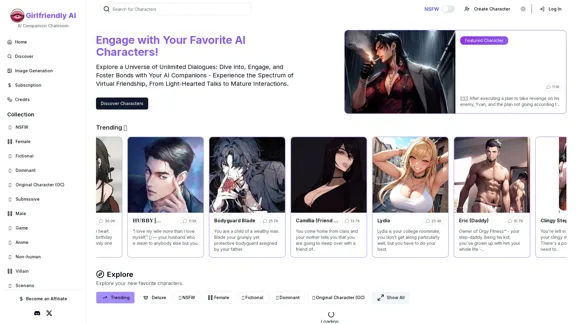

Girlfriendly AI - Chat AI avec personnages NSFW sans filtre

Girlfriendly AI - Chat AI avec personnages NSFW sans filtreIA adaptée aux filles. Explorez des conversations IA engageantes, développez des personnalités IA SFW et NSFW uniques et interagissez avec plus de 38 000 chatbots IA. © 2024 IA Girlfriendly.

52.60 K