Reflection-70B es un modelo de lenguaje avanzado de código abierto diseñado para abordar el problema de las alucinaciones en los sistemas de IA. Construido sobre el marco Llama-3.1, incorpora tokens especiales para estructurar el proceso de razonamiento y emplea mecanismos de control más estrictos para reducir la generación de información falsa. El modelo ha demostrado un rendimiento superior en varios puntos de referencia, superando incluso a algunos modelos de código cerrado.

Reflection-70B: IA libre de alucinaciones

Reflection-70B es un modelo de lenguaje avanzado de código abierto que busca abordar el problema de las alucinaciones en los sistemas de inteligencia artificial

Introducción

Funcionalidad

-

Arquitectura avanzada

- Construido sobre el marco Llama-3.1

- Incorpora tokens especiales: <thinking>, <reflection> y <output>

- Estructura el proceso de razonamiento para mejorar la precisión

-

Entrenamiento integral

- Entrenado con datos sintéticos generados por Glaive

- Utiliza grandes conjuntos de datos para mejorar el procesamiento del lenguaje natural

-

Rendimiento superior

- Sobresale en puntos de referencia: MMLU, MATH, IFEval y GSM8K

- Supera a modelos de código cerrado como GPT-4o en varias pruebas

-

Reducción de alucinaciones

- Emplea mecanismos de control más estrictos durante la verificación de información

- Reduce significativamente la generación de información falsa

- Mejora la confianza y fiabilidad del usuario

-

Disponibilidad de código abierto

- Pesos disponibles en Hugging Face

- Lanzamiento de API planificado a través de Hyperbolic Labs para una integración más fácil

-

Desarrollo continuo

- Se espera pronto una versión más potente, Reflection-405B

- Se anticipa que superará significativamente a los mejores modelos propietarios

¿Cómo usar?

-

Acceder a Reflection-70B:

- Visita https://reflection70b.com

- Haz clic en el botón "Iniciar"

- Comienza a chatear con el modelo

-

Explorar puntos de referencia:

- Revisa la tabla de rendimiento para comparar con otros modelos

- Enfócate en métricas como GPQA, MMLU, HumanEval, MATH y GSM8K

-

Entender la tecnología:

- Familiarízate con la técnica de Reflection-Tuning

- Aprende cómo los tokens especiales estructuran el proceso de pensamiento del modelo

-

Mantenerse actualizado:

- Está atento al lanzamiento de Reflection-405B

- Sigue a Hyperbolic Labs para obtener información sobre el lanzamiento de la API

Preguntas Frecuentes

P: ¿Qué es Reflection-70B? R: Reflection-70B es un modelo de lenguaje avanzado de código abierto diseñado para minimizar las alucinaciones y mejorar la precisión en las salidas generadas por IA a través de una técnica llamada Reflection-Tuning.

P: ¿Cómo funciona Reflection-Tuning? R: Reflection-Tuning enseña al modelo a detectar y corregir sus propios errores de razonamiento introduciendo tokens especiales como <thinking>, <reflection> y <output> para estructurar su proceso de pensamiento.

P: ¿En qué puntos de referencia sobresale Reflection-70B? R: Reflection-70B ha demostrado un rendimiento superior en varios puntos de referencia, incluyendo MMLU, MATH, IFEval y GSM8K, superando incluso a modelos de código cerrado como GPT-4o.

P: ¿Cómo reduce Reflection-70B las alucinaciones? R: Al emplear mecanismos de control más estrictos durante las etapas de verificación de información, Reflection-70B reduce significativamente la generación de información falsa, mejorando la confianza y fiabilidad del usuario.

P: ¿Dónde puedo acceder a Reflection-70B? R: Los pesos de Reflection-70B están disponibles en Hugging Face, y se planea lanzar una API a través de Hyperbolic Labs para facilitar la integración en aplicaciones.

Evaluación

-

Reflection-70B representa un avance significativo en los modelos de lenguaje de código abierto, particularmente en abordar el problema crítico de las alucinaciones de IA. Su rendimiento en varios puntos de referencia es impresionante, a menudo superando a competidores de código cerrado.

-

La arquitectura del modelo, que incorpora tokens especiales para un razonamiento estructurado, es innovadora y muestra promesa en mejorar la fiabilidad de la IA. Este enfoque podría establecer un nuevo estándar para sistemas de IA transparentes y confiables.

-

La disponibilidad de Reflection-70B como modelo de código abierto es encomiable, potencialmente acelerando la investigación y el desarrollo en el campo de los modelos de lenguaje de IA. Sin embargo, la efectividad de su implementación en aplicaciones del mundo real aún está por verse.

-

Aunque el modelo muestra resultados impresionantes en puntos de referencia, es importante notar que el rendimiento en el mundo real puede variar. Pruebas más extensas en escenarios prácticos diversos proporcionarían una imagen más clara de sus capacidades y limitaciones.

-

El desarrollo continuo de Reflection-405B indica un compromiso con la mejora continua. Sin embargo, la comunidad de IA debe permanecer vigilante sobre posibles sesgos o limitaciones que puedan surgir a medida que el modelo se escala.

-

El enfoque en reducir las alucinaciones es crucial para construir confianza en los sistemas de IA. Sin embargo, los usuarios aún deben abordar el contenido generado por IA con pensamiento crítico y no confiar únicamente en las salidas del modelo sin verificación.

Sitios web relacionados

Vectorize: IA rápida, precisa y lista para producción - Vectorize

Vectorize: IA rápida, precisa y lista para producción - VectorizeRápida, precisa, IA lista para producción. Convierte tus datos no estructurados en índices de búsqueda vectorial perfectamente optimizados, diseñados específicamente para la Generación Aumentada por Recuperación

68.24 K

Novia virtual: puedes chatear con una chica virtual. Habla sobre tus intereses, comparte pensamientos o prueba tus habilidades de coqueteo.

0

Exie – el primer asistente de comercio electrónico impulsado por IA para Instagram Direct

Exie – el primer asistente de comercio electrónico impulsado por IA para Instagram DirectExie ayuda a las empresas a simplificar y automatizar la comunicación, el servicio y el soporte al cliente en Instagram.

1.43 K

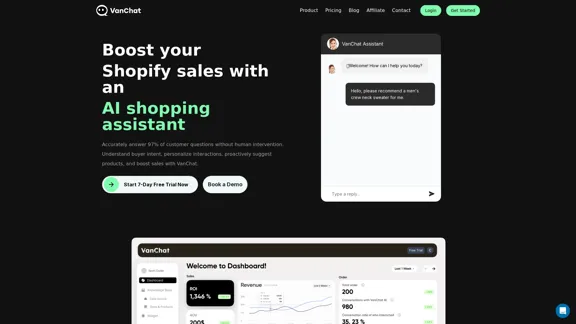

Responda con precisión al 97% de las preguntas de los clientes sin intervención humana. Comprenda la intención del comprador, personalice las interacciones, sugiera productos de manera proactiva y aumente las ventas con VanChat.

32.53 K

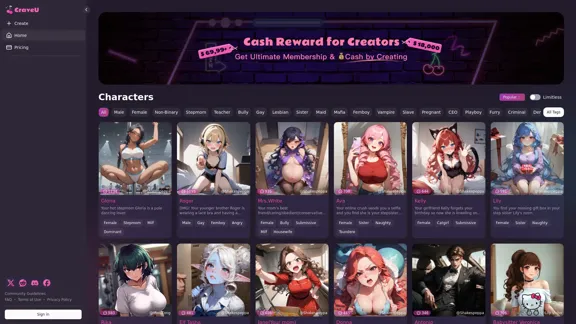

CraveU AI: primer chatbot de IA NSFW para chat sexual con IA y hentai con IA | CraveU IA

CraveU AI: primer chatbot de IA NSFW para chat sexual con IA y hentai con IA | CraveU IADescubre CraveuAI para chat sexual de IA de primera categoría y hentai de IA, ofreciendo experiencias NSFW de IA personalizadas e inmersivas. ¡Explora tus fantasías hoy!

771.00 K

FapAI - El primer bot de sexting con IA para chat sexual

FapAI - El primer bot de sexting con IA para chat sexualExperimenta el bot de sexting AI definitivo diseñado para interacciones de chat sexual atractivas e íntimas. ¡Descubre conversaciones fluidas, divertidas y discretas hoy!

191.03 K

El motor de inferencia LPU™ de Groq es una plataforma de hardware y software que ofrece una velocidad de cómputo excepcional, calidad y eficiencia energética. Groq proporciona soluciones en la nube y locales a gran escala para aplicaciones de IA. Con sede en Silicon Valley y fundada en 2016. El LPU y los sistemas relacionados están diseñados, fabricados y ensamblados en América del Norte.

1.41 M